Dem zugrunde liegend stellen sich mir dann noch die Fragen: „Ist, wenn nichts schief geht, alles gut?“ - und umgekehrt - „Geht, wenn alles gut wird, nichts schief?“ Für einige mag dies nach Wortklauberei klingen, aber für mich spiegeln sie die Unterschiede in der Grundphilosophie hinter Safety I und Safety II wider.

Mit Safety I kennen sich die meisten von uns gut aus. Wir haben im Rahmen unserer Pilotenausbildung viel über Fehlerketten, Domino-Effekt, Schweizer-Käse-Modell (nach J. Reasons) gelernt – der ein oder andere hat sich vielleicht sogar schon mit Bow-Tie Analysis oder Failure Mode and Effects Analysis beschäftigt.

Safety II ist hingegen für viele von uns eher neu. Einige Erkenntnisse aus dem obigen Webinar bilden aus unserer Sicht eine gute Basis, Euch einige Inhalte von Safety II näherzubringen. Als Grundlage gehen wir in einer kurzen Serie auf diverse Vorträge, welche im Rahmen des Webinars gehalten wurden, ein. In diesen Vorträgen stellten Vertreter von Behörden, Forschung und aus der Operation (Airlines und EUROCONTROL) ihre Erfahrungen und Ansichten bezüglich Safety II vor. Komplementiert wurde dies durch einen Blick über den Tellerrand der Fliegerei, indem auch zwei Ärzte Safety II aus ihrer Sicht betrachteten.

What you look for is what you find!

Wir beginnen mit dem Vortrag „What you look for is what you find!” von Prof. E. Hollnagel, der als Urvater von Safety II1 gilt. Hollnagel vertritt die Meinung, dass das Lernen aus Fehlern allein nicht mehr ausreicht, um das bestehende Sicherheitsniveau zu halten, geschweige denn zu verbessern. Eine Fokussierung lediglich auf Zwischenfälle betrachtet nur kleine Ausschnitte der allgemeinen Performance. Wenn wir nur die Events betrachten und zählen, in denen etwas schiefläuft, misst das nicht wie sicher das System ist, es misst, wieviel an Sicherheit im System fehlt.

Hollnagel zitierte in diesem Zusammenhang Marit de Vos von der Universität Leiden: „In der Flugsicherheit ist es so, als ob wir versuchen würden, etwas über die Ehe zu lernen, indem wir nur die Scheidung studieren“.

Das Lernen aus Fehlern allein reicht nicht mehr aus, um das bestehende Sicherheitsniveau zu halten, geschweige denn zu verbessern. Eine Fokussierung lediglich auf Zwischenfälle betrachtet nur kleine Ausschnitte der allgemeinen Performance.

Er wies hierbei noch auf einige der Unterschiede in den jeweiligen Betrachtungsweisen hin, insbesondere dann, wenn nur darauf geachtet wird, warum etwas schiefgeht:

- Auswahl des Events aufgrund der Schwere der Auswirkungen

- Die Fälle sind nicht wirklich häufig und regelmäßig (Volumen an Daten, die zur Verfügung stehen, ist gering)

- Die Fälle weisen meist wenig Gemeinsamkeiten auf

- Es ist unter Umständen schwer, ein Lernergebnis aus diesen Fällen zu extrahieren

Demgegenüber steht die Betrachtungsweise, wenn etwas gut gelaufen ist:

- Auswahl aufgrund einer gewissen Häufigkeit

- Fälle können leicht gefunden werden (größerer Datensatz steht zur Verfügung)

- Fälle haben Gemeinsamkeiten

- Es ist leicht ein Lernergebnis aus den Daten zu extrahieren

Hollnagel betont aber ausdrücklich, dass Safety I und Safety II nicht in Konkurrenz zueinanderstehen, sondern sich komplementieren – eine ganzheitliche Betrachtung ist wichtig.

Dies bestätigte Prof. J. Holbrook (NASA) in seinem Vortrag. Er beschäftigt sich im Rahmen diverser Forschungsprojekte bei der NASA seit einiger Zeit mit Safety II und dabei insbesondere auch damit, welche Daten erfasst und untersucht werden. Einige Frage in diesem Zusammenhang sind:

- Welche Daten sind derzeit verfügbar?

- Wie und warum werden diese Daten erhoben?

- Welche Daten könnten erhoben werden, werden aber nicht?

- Wie und warum werden die Daten analysiert?

- Wie verwandeln wir Daten in Informationen?

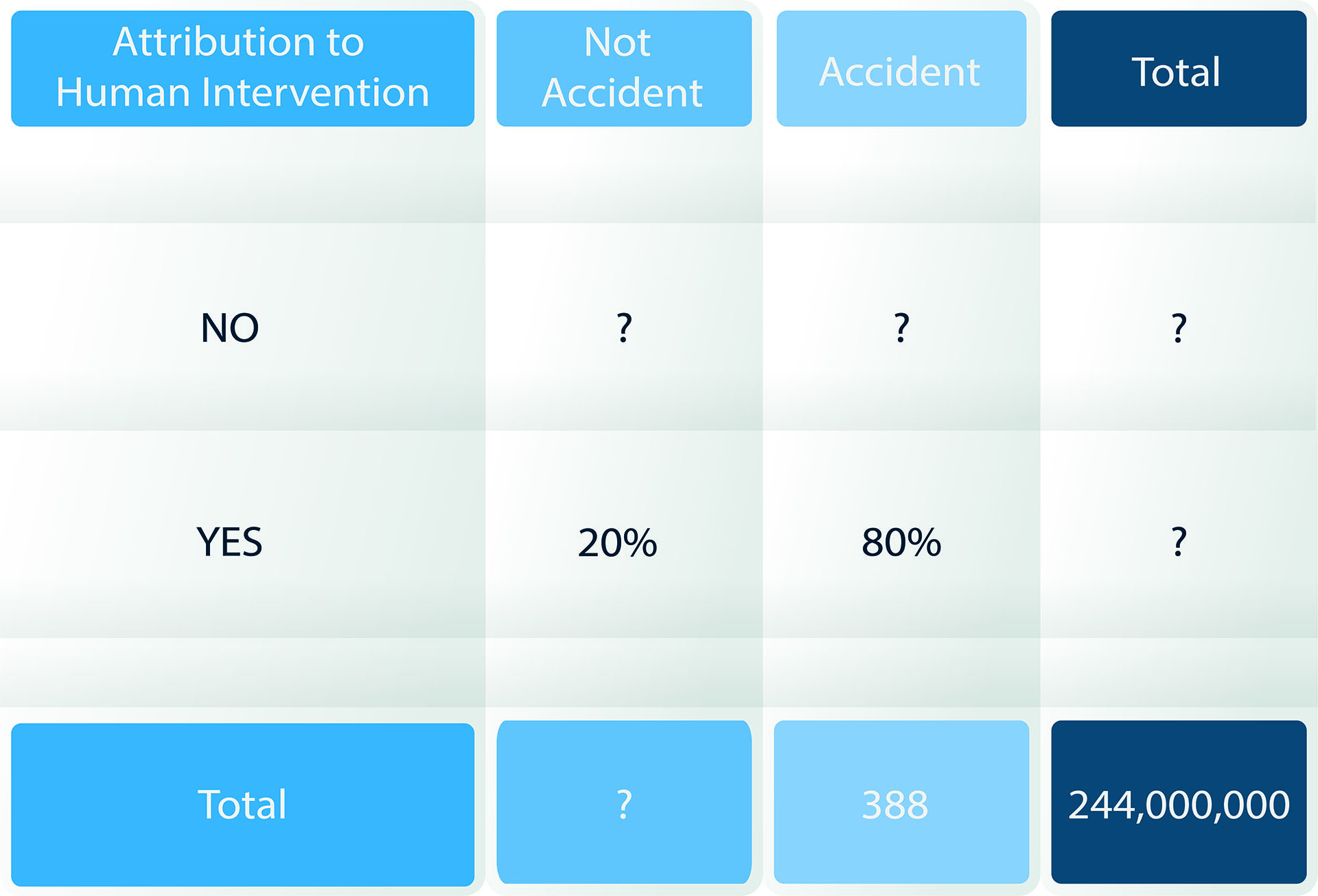

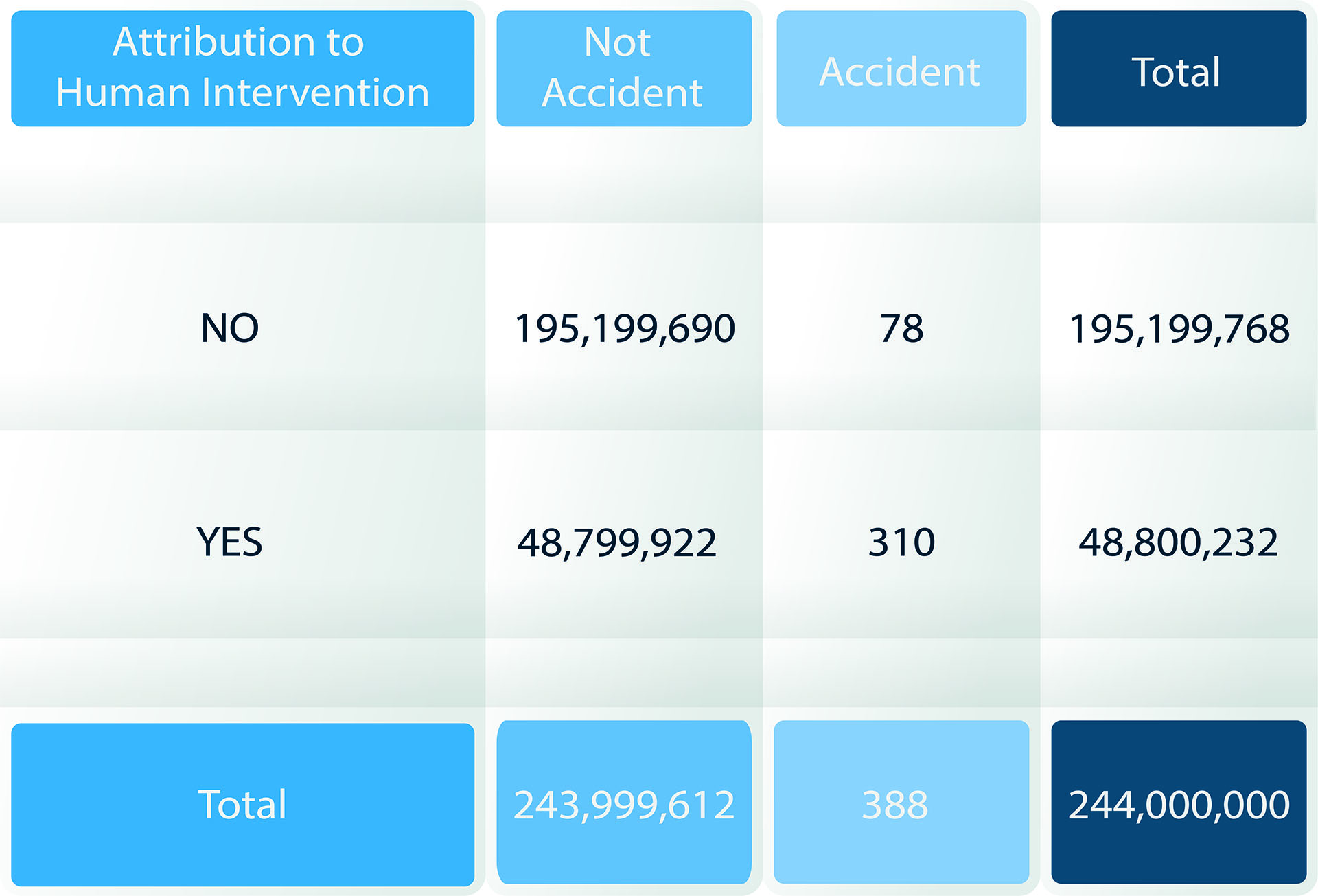

Erste Analysen haben hierbei gezeigt, dass die Anzahl sicherheitsrelevanter menschlicher Eingriffe die Zahl menschlicher Fehler in der Luftfahrt bei weitem übertreffen. Laut einer Studie des Performanced Based Aviation Rule Making Committe (PARC) und des Commercial Aviation Safety Team (CAST) von 20132, greifen Piloten in 20% der Flüge ein, um unerwünschtes Systemverhalten zu korrigieren. Diese Flüge gehen dann aber als „ohne besondere Ereignisse“ in die Gesamtstatistik ein und werden meistens nicht weiter untersucht. Demgegenüber werden Unfälle meist intensiv untersucht und hier wird in vielen solcher Untersuchungen und Studien (z.B. Weigmann & Shappell, 2001)3 immer wieder darauf hingewiesen, dass menschliches Versagen ein entscheidender Faktor in 70% bis 80% tatsächlicher Unfälle ist.