„Mit der Weiterentwicklung unserer Technologie […] schaffen wir Systeme […], die die Risiken für Betreiber, Passagiere, Unbeteiligte und zukünftige Generationen erhöhen.“1 Charles Perrow, aus dessen viel beachtetem Buch „Normal Accidents“ das Zitat stammt, hatte nichts gegen neue Technologien. Er wies aber darauf hin, dass sowohl die wachsende Komplexität als auch enge Verzahnung von Systemen zu neuen Sicherheitsrisiken führen kann, obwohl sie diese eigentlich hätten verringern sollen. Es ist eine Dualität, die wir auch in der Luftfahrt beobachten. Dort hat die zunehmende Automatisierung der letzten Jahrzehnte die Arbeitsbelastung von Flugzeugbesatzungen reduziert. Gleichzeitig konnten wir erkennen, dass die Performance der Besatzung bei einer Systemstörung mit zunehmendem Automatisierungsgrad abnimmt.2 Und noch etwas konnten wir feststellen: In 46 Prozent der Unfallberichte und 60 Prozent der Berichte über schwere Vorfälle wird das unerwartete Verhalten automatisierter Systeme als Grund angegeben.3

Wie überraschend, aber auch schwierig es sein kann, dieses unerwartete Systemverhalten zu registrieren, zeigt der Fall der Turkish Airlines (TK) 1951.4 Aufgrund einer Fehlfunktion des Radio-Altimeters wurde dem Autopiloten der Boeing 737-800 im Landeanflug auf den Flughafen Amsterdam Schiphol in einer Höhe von 2.000 Fuß eine Höhe über Grund von minus 8 Fuß gemeldet. Für das Autothrust-System des Autopiloten bedeutete dies, das Aufsetzen des Flugzeugs stand unmittelbar bevor. Das System aktivierte den RETARD Mode, der im Primary Flight Display angezeigt wurde, woraufhin die Triebwerksleistung auf Leerlauf verringert wurde. Die Besatzung, die aus einem erfahrenen Kapitän und zwei Copiloten bestand, erkannte weder die falsche Autopilot-Stellung noch die damit einhergehende Triebwerksreduktion. Zu diesem Zeitpunkt flog die Boeing 737-800 noch zu hoch und zu schnell, die Leerlaufstellung der Triebwerke entsprach daher den Anforderungen.

Als das Flugzeug etwas später in einer Höhe von 1.300 Fuß auf dem Gleitpfad des ILS stabilisiert war, hätte das Autothrust-System die Triebwerksleistung im Normalbetrieb wieder erhöhen müssen. Wegen der Fehlfunktion des Radio-Altimeters und des nun aktivierten RETARD Mode blieben die Triebwerke jedoch im Leerlauf. Von der Besatzung immer noch unbemerkt, nahm die Geschwindigkeit weiter ab, bis in der Höhe von 460 Fuß der Stick Shaker als Warnung vor einem drohenden Strömungsabriss aktiviert wurde. Danach gelang es der Besatzung nicht mehr, das Flugzeug unter Kontrolle zu bringen. Selbst während sie versuchte, das Flugzeug abzufangen, erkannte sie den aktivierten RETARD Mode nicht, sodass die Triebwerksleistung immer wieder zurückgefahren wurde. Um die Triebwerksleistung zu erhöhen, hätte die Besatzung das Autothrust-System abschalten müssen. Beim Absturz des Flugzeugs kurz vor der Landebahn verloren neun Menschen ihr Leben, darunter alle drei Piloten.

Wie bei fast allen Unfällen in der Luftfahrt gab es eine ganze Reihe Gründe – unter ihnen nicht zuletzt die unzureichende Zusammenarbeit der Besatzung –, die zu diesem Unfall beitrugen, doch auf sie einzugehen, würde den Umfang dieses Beitrags sprengen. Festzuhalten bleibt: Zu den entscheidenden Gründen gehörte die verhängnisvolle Fehlfunktion des Radio-Altimeters und der dadurch viel zu früh aktivierte RETARD Mode des Autopiloten, der von den Piloten bis zuletzt unbemerkt blieb. Die Automatisierung, die den Piloten das Fliegen erleichtern sollte, hatte sich gegen sie gewendet.

Natürlich wäre es falsch, nun zum manuellen Flugbetrieb zurückzukehren, um Unfälle wie diesen künftig zu vermeiden. Allerdings wäre es wünschenswert, mehr über die Häufigkeit unerwarteten Systemverhaltens zu erfahren. Leider gibt es zu diesem Thema bislang nur wenige aussagekräftige Studien.5

Von „Automation Surprise“ oder „Automatisierungsüberraschung“ sprechen wir, wenn ein automatisiertes System eine Aktion ausführt (oder nicht ausführt), mit der die oder der Bedienende nicht gerechnet hat.6 Hierfür kann es zwei Ursachen geben: Entweder agiert das System fehlerhaft, etwa weil Sensoren falsche Daten liefern oder Programmierungsfehler vorliegen. Ebenso kann es an Besatzungsmitgliedern liegen, deren Kenntnisstand ungenügend ist oder die eine Situation falsch einschätzen. Im zweiten Fall handelt es sich um einen klassischen Human Factor, der hier jedoch nicht von Interesse sein soll. Vielmehr steht in der nachfolgenden Betrachtung das fehlerhafte Systemverhalten – die Automatisierungsanomalie als Ursache einer Automatisierungsüberraschung – im Fokus.

Die Vereinigung Cockpit (VC) hat im Rahmen der Reduced Crew Operation Taskforce der European Cockpit Association (ECA) 2021 ein Pilot Resilience Survey (nachfolgend ECA-Studie) durchgeführt. Hierzu wurden Pilotinnen und Piloten von Verkehrsflugzeugen befragt, mit welchen operativen, technischen und betrieblichen Anforderungen sie im Flugbetrieb konfrontiert werden und wie diese sich auf dessen Sicherheit auswirken, insbesondere angesichts des sich entwickelnden neuen Trends zur Reduzierung der Eingriffe von Besatzungen in einzelnen Phasen des Flugs. An der Studie beteiligten sich über 1.600 Pilotinnen und Piloten, knapp 17 Prozent der Mitglieder der VC. Von diesen machten 1.097 (68 Prozent) Angaben zu unerwartetem Systemverhalten (inappropriate automatic system behavior) ihres Flugzeugs.

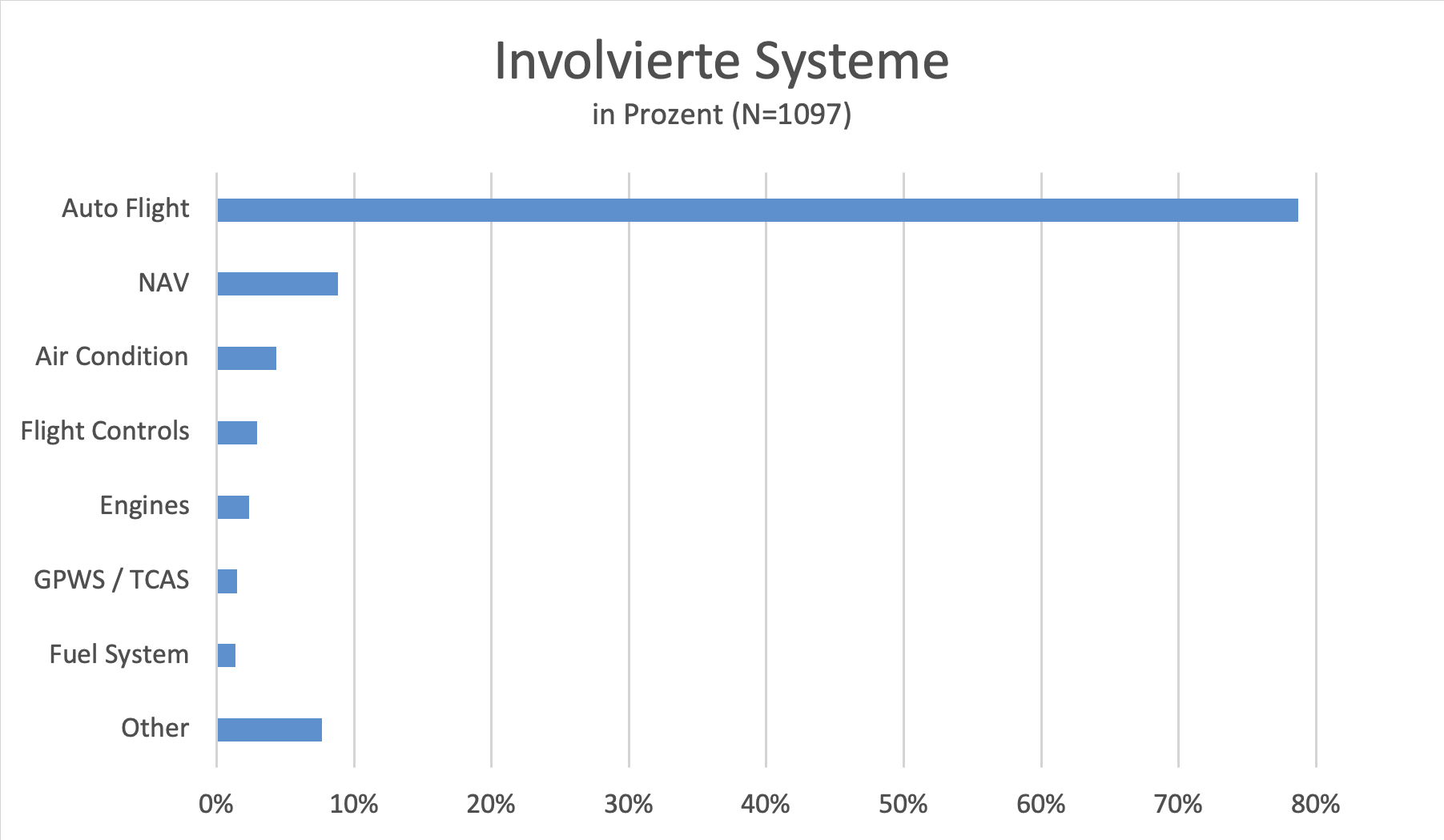

Die Befragung zeigt zunächst, dass die Automatisierungsanomalien sich überwiegend auf den Autopiloten beziehen: Nahezu 80 Prozent der Ereignisse waren auf dessen unerwartetes Verhalten zurückzuführen (Abbildung 1). Das ist nicht überraschend, der Autopilot ist das zentrale System zur Steuerung eines Flugzeugs. Als Reaktion auf dessen Störung haben die Besatzungen die Flugsteuerung meistens manuell fortgesetzt (56 Prozent). In nur 10 Prozent der Fälle wurde der Autopilot danach wieder aktiviert.

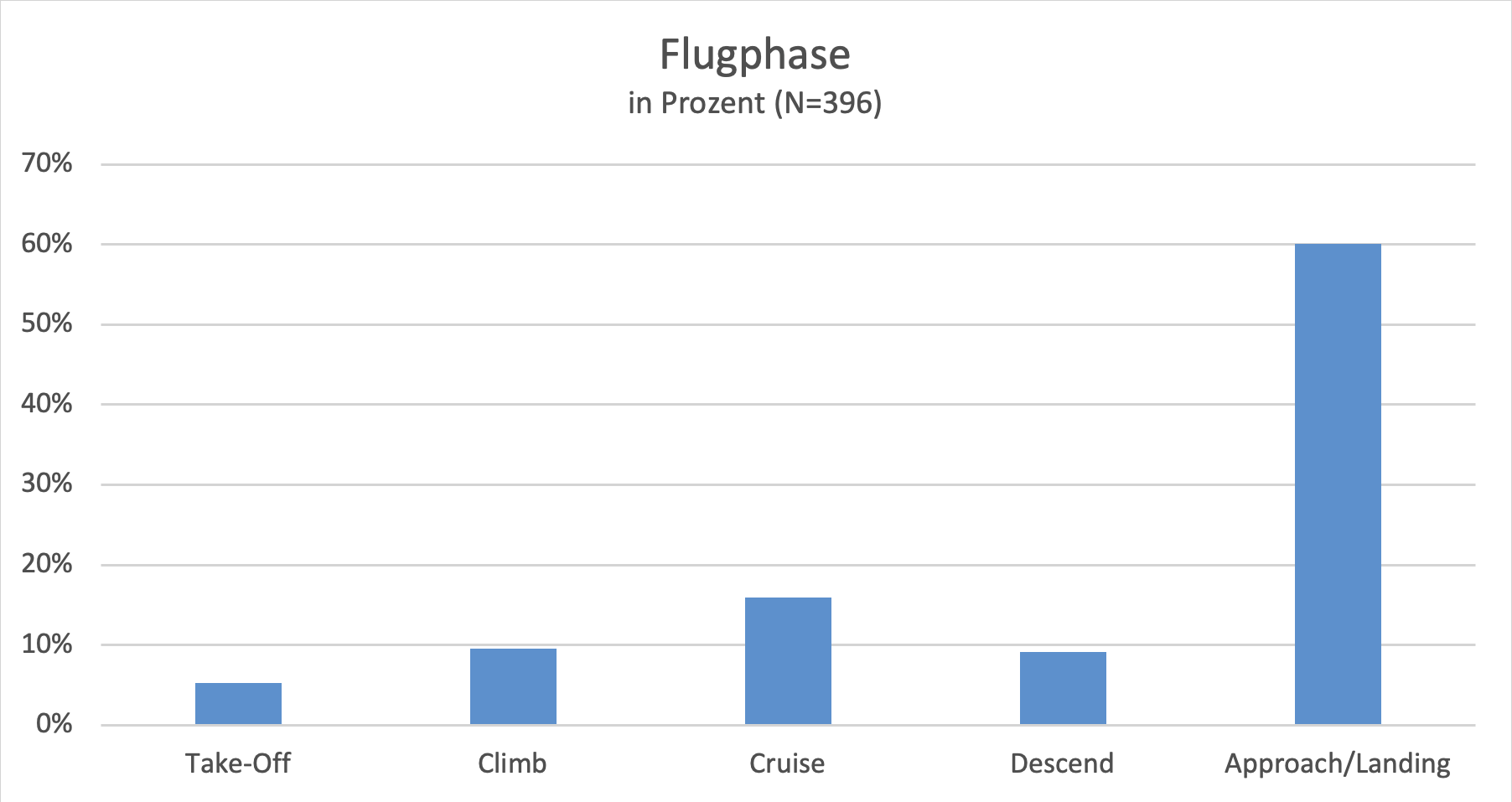

Die Störungen wurden am häufigsten während des Landeanflugs beobachtet: 60 Prozent der Automatisierungsanomalien entfallen auf diese Flugphase (Abbildung 2). Im Verhältnis zur Flugzeit der Verkehrsflugzeuge ist dies deutlich überproportional, allerdings ist der Landeanflug auch die dynamischste Phase eines Flugs, bei der die involvierten Systeme mit oftmals schnell wechselnden Einflussfaktoren konfrontiert werden. Außerdem ist die Aufmerksamkeit der Besatzung in dieser Flugphase sehr stark auf den Autopiloten gerichtet. Diese Angaben erlauben jedoch noch keine Aussagen über die Schwere einer beobachteten Anomalie.

Bei einer an die ECA-Studie anhängten zusätzlichen Befragung wollte die ESMT Berlin weitergehende Informationen über die Art der Störung und den Einfluss auf den Flugverlauf gewinnen. Da der Fragebogen der ESMT Berlin für die ECA-Studienteilnehmenden erst nach Abschluss der ECA-Studie freigeschaltet wurde, machten deutlich weniger Teilnehmende (N=107) Angaben. Dennoch kamen interessante Aspekte zum Vorschein.

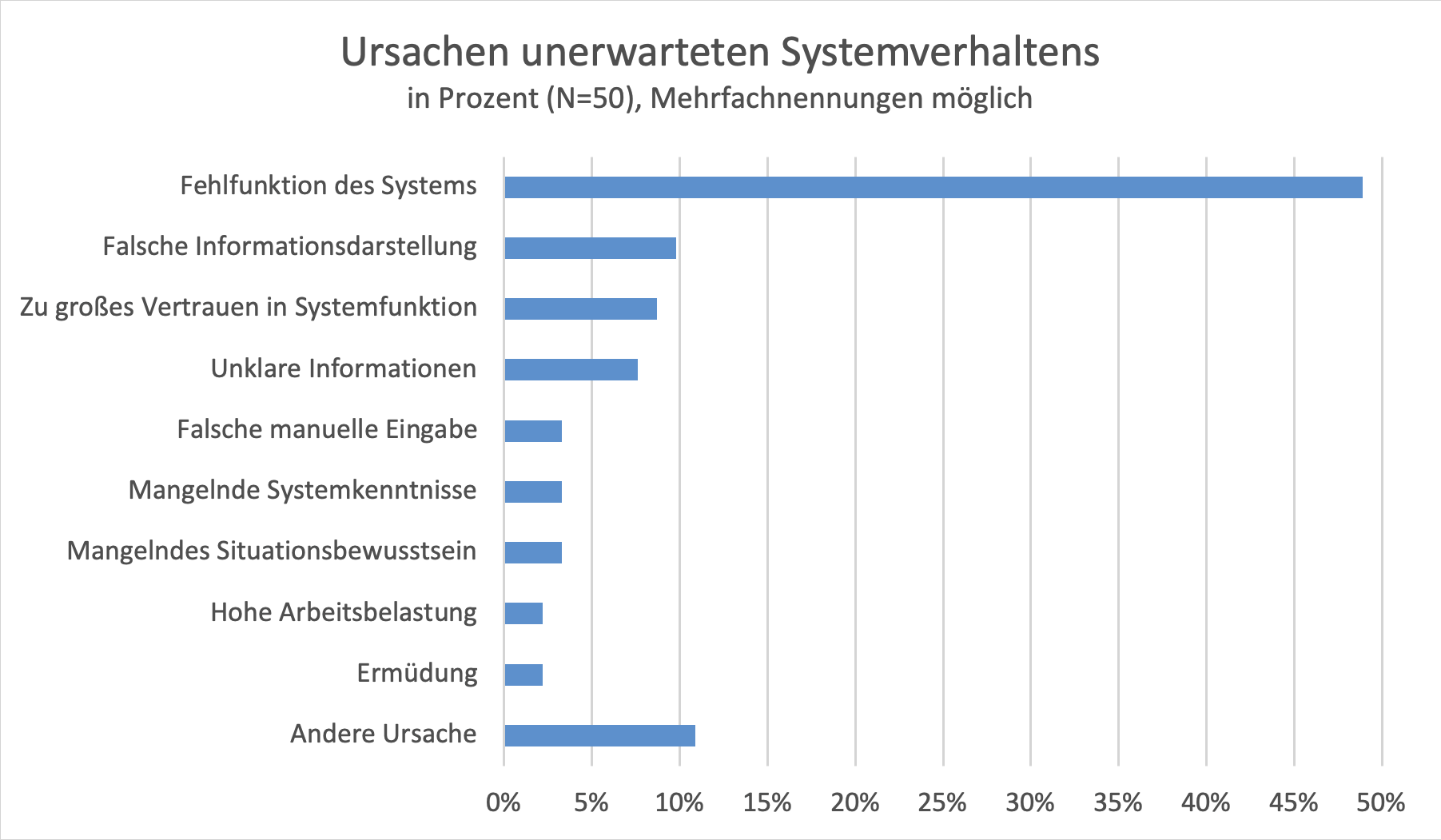

So zeigen die Angaben, dass das unerwartete Systemverhalten in den meisten Fällen auf einem Fehler im System oder einer fehlerhaften Informationsdarstellung basierte (Abbildung 3). Nur 14 Prozent der Ereignisse beruhten auf falschen Eingaben.

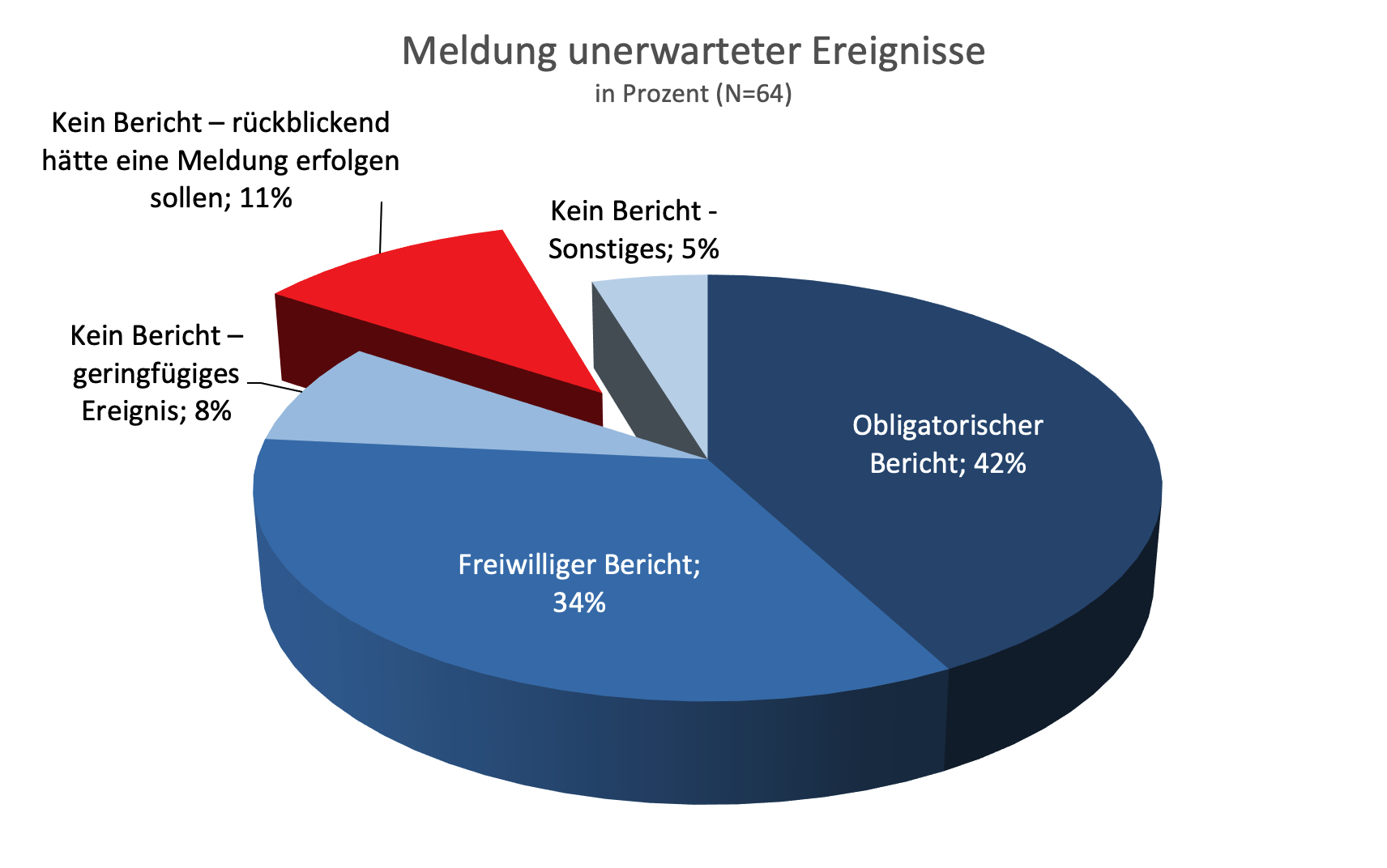

Wir müssen berücksichtigen, dass es sich bei den Angaben um eigene Einschätzungen der befragten Besatzungen handelt. Allerdings wurden die Ereignisse größtenteils als berichtspflichtige Vorgänge oder auf freiwilliger Basis dokumentiert (76 Prozent), was eine Fehlklassifizierung unwahrscheinlich macht (Abbildung 4).

Auffällig ist, dass die Beteiligten bei knapp der Hälfte (48 Prozent) der nicht berichteten Automatisierungsanomalien einen Bericht für angebracht gehalten hätten. Dies könnte ein Hinweis auf eine zu geringe Berichterstattung von Automatisierungsanomalien sein. Zu den nicht gemeldeten Ereignissen der Studie zählte auch die unerwartete Leistungsreduzierung der Triebwerke auf Leerlauf bei der Landung, die auf einen Fehler des Radio-Altimeters zurückzuführen war – ein Szenario, das dem eingangs beschriebenen Unfall der TK1951 erschreckend ähnlich ist. In diesem Fall hat der Berichtende den Ausfall des Radio-Altimeters wie vorgeschrieben dokumentiert, nicht jedoch die Überraschung der Besatzung während des Landeanflugs.

Der Fall der TK1951 ist in einem weiteren Zusammenhang interessant: Der falsch aktivierte RETARD Mode des Autothrust-Systems hatte nicht zu einer Aktion des Systems geführt, sondern die Triebwerksleistung ab einem bestimmten Punkt nicht, wie eigentlich vorgesehen, automatisch erhöht. Dieses unerwartete passive Verhalten eines Systems ist wegen der fehlenden Aktion generell schwieriger zu bemerken als ein fehlerhaftes aktives Verhalten. In unserer Studie handelte es sich bei 29 Prozent der Fälle unerwarteten Systemverhaltens um passive Ereignisse.

Die überwiegende Mehrheit der Befragten (86 Prozent) gab an, die beobachteten Automatisierungsanomalien selbst bemerkt zu haben. Nur 5 Prozent erklärten, ein anderes Besatzungsmitglied habe sie auf die Anomalie hingewiesen. Um diese Asymmetrie zu verstehen, wären mehr Informationen notwendig. Sie könnte darauf zurückzuführen sein, dass sich die Befragten stärker an Ereignisse erinnern, bei denen sie das unerwartete Systemverhalten selbst registrierten. Sie könnte aber auch ein Hinweis auf unzureichende Kommunikation im Cockpit sein.

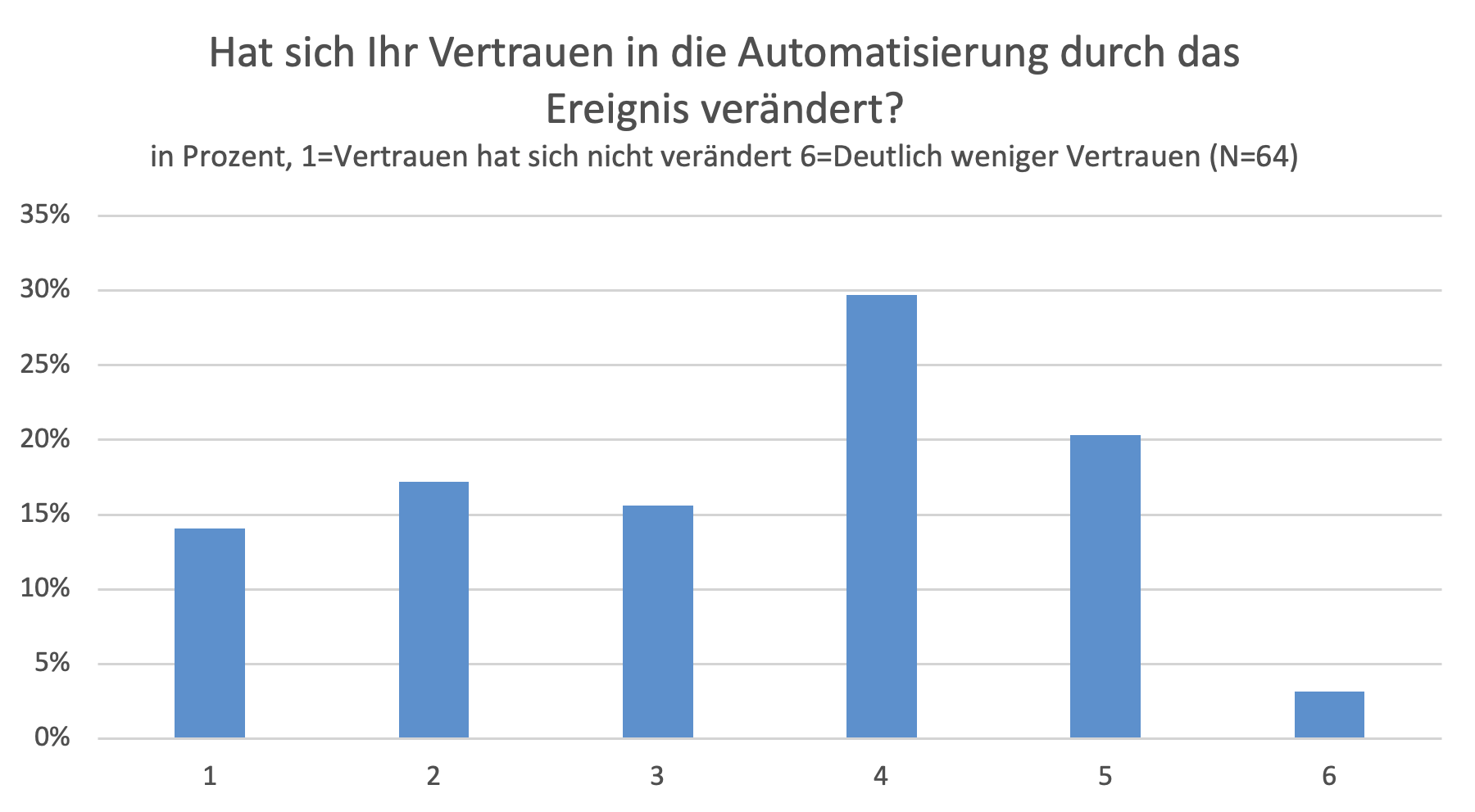

Die Erfahrung unerwarteten Systemverhaltens hat zu einem Vertrauensverlust in die Automatisierung geführt. Über 50 Prozent der Befragten gaben an, dass ihr Vertrauen in die Automatisierung aufgrund unerwarteten Systemverhaltens abgenommen hat. Nur 14 Prozent fühlten sich davon unbeeinträchtigt (Abbildung 5).

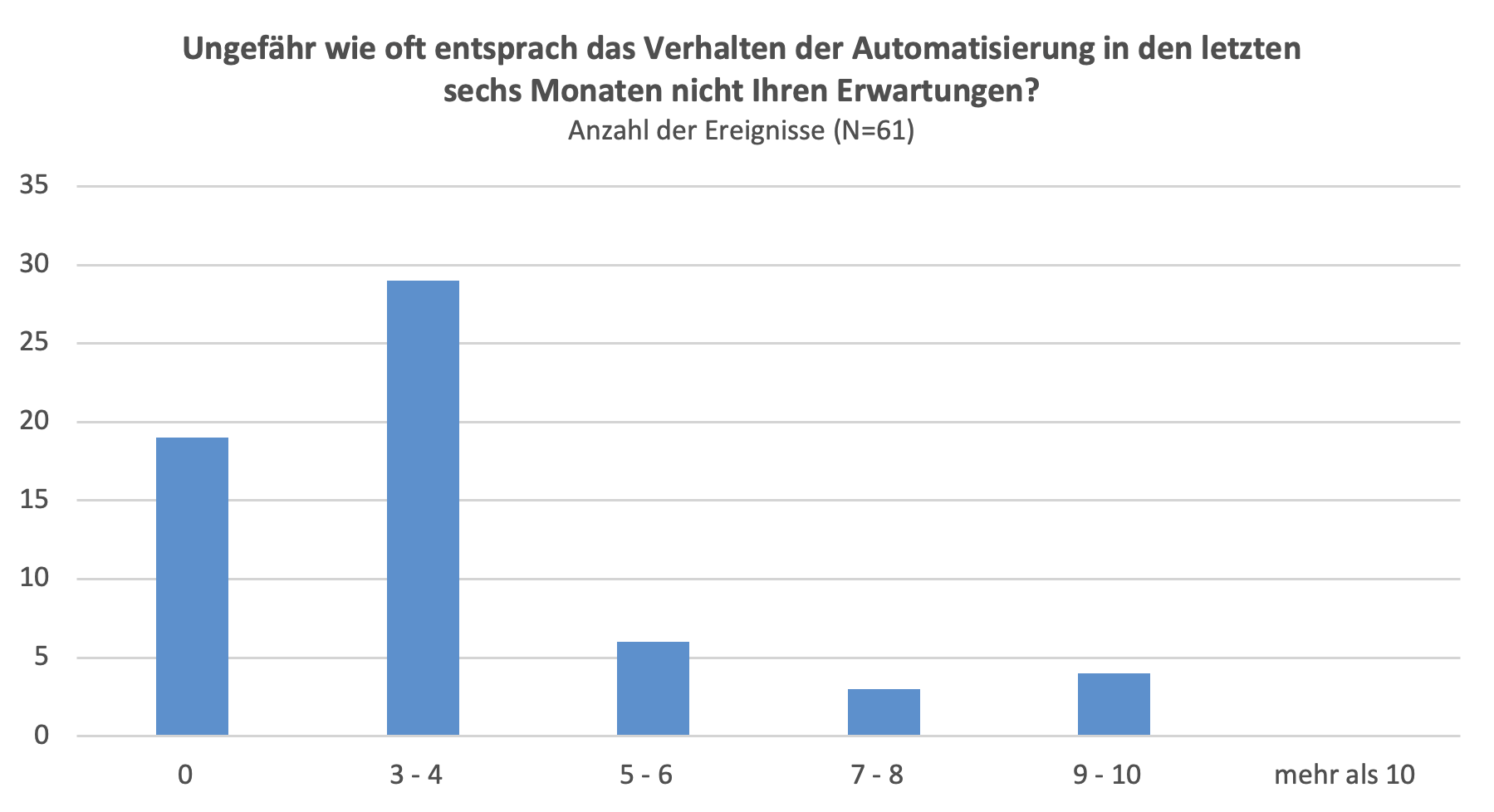

Abschließend bleibt die Frage, wie häufig unerwartetes Systemverhalten im Flugbetrieb tatsächlich vorkommt. Hier liefert die Abbildung 6 einen Anhaltspunkt: Mehr als zwei Drittel der Befragten gaben an, in den vergangenen sechs Monaten mindestens ein Mal mit unerwartetem Systemverhalten konfrontiert worden zu sein.

Die kleine Stichprobengröße insbesondere der ESMT Studie erlaubt leider nur Hinweise auf den Umfang und die Signifikanz von Automatisierungsanomalien. Aufgrund der weiter fortschreitenden Automatisierung im Cockpit erscheint es jedoch angebracht, nicht nur das Fehlverhalten von Systemen, sondern auch die Reaktionen der Besatzung in den Fokus zu rücken. Sich darauf zu verlassen, dass der Mensch ein Systemversagen als letzte Sicherung auffängt, greift zu kurz, auch wenn ein Studienteilnehmer dies als Selbstverständlichkeit darstellte: „Folgen des unerwarteten Automatisierungsereignisses: Keine, dafür sind Piloten da.“ Wichtig ist in jedem Fall die konsequente Erfassung und Analyse von Automatisierungsanomalien, um auch zukünftig Gefahren für die Sicherheit frühzeitig zu erkennen.